Che Facebook stesse attraversando la crisi più seria almeno dallo scandalo di Cambridge Analytica era già evidente da inizio ottobre, quando il Wall Street Journal aveva pubblicato le prime rivelazioni ottenute dalla whistleblower Frances Haugen, ex dipendente dell’azienda, su diverse pratiche dannose di cui Facebook era consapevole. Questa settimana, però, abbiamo avuto la conferma che si trattava soltanto della punta dell’iceberg.

Un consorzio di giornalisti statunitensi lunedì ha cominciato a pubblicare in simultanea una serie infinita di articoli – al momento ce ne sono almeno quaranta ma continuano a crescere – che esaminano una mole altrettanto immensa di documenti interni, email e dati della compagnia che Haugen ha raccolto prima di lasciare Facebook a inizio anno: i Facebook Files. Sembra che i leak continueranno a essere pubblicati per almeno altre sei settimane. E infatti la compagnia di Menlo Park è sulla difensiva già da giorni e sta cercando in tutti i modi di sminuire l’impatto dei Facebook Files, screditando Haugen e sostenendo principalmente che si tratterebbe di una macchina del fango.

Ci sono sicuramente alcuni puntini sulle i da mettere se si vuole comprendere i Facebook Files. Il primo è che, come ha spiegato un’ex dipendente dell’azienda, va considerato che tantissime delle comunicazioni interne raccolte da Haugen non sono tutte grandi discussioni tra persone che ricoprono ruoli di responsabilità o potere all’interno dell’azienda: molte sono semplicemente conversazioni tra dipendenti qualsiasi, che non hanno necessariamente il polso della situazione o di ciò che sta avvenendo su altri team interni all’azienda. Il secondo è che i Facebook Files descrivono una compagnia mastodontica all’interno della quale nessuno è davvero sicuro di cosa stia succedendo.

Pur con questi presupposti, quello che emerge dai Facebook Files resta un’accusa molto potente non solo contro le azioni (o inazioni) che hanno causato danni politici e sociali in diversi Paesi del mondo, ma anche contro una dirigenza che sembra non voler o saper mettere la sicurezza dei suoi utenti prima del profitto.

Il nome di Mark Zuckerberg viene fatto più volte: il fondatore della compagnia è accusato, ad esempio, di aver mentito al Congresso statunitense quando l’hanno scorso ha detto che Facebook rimuove il 94% dell’hate speech sulla piattaforma ancora prima che un essere umano la segnali. I documenti interni mostrano che la compagnia starebbe invece rimuovendo appena il 5% di tutto l’hate speech che c’è sulla loro piattaforma.

Zuckerberg sarebbe anche intervenuto personalmente per assicurarsi che una legge repressiva istituita dal governo vietnamita – che chiedeva a Facebook di cancellare i contenuti “anti-stato” sulle proprie piattaforme – fosse applicata attentamente. È soltanto uno di diversi casi in cui il team dedicato all’integrità di Facebook, il cui lavoro era rendere meno dannosa la piattaforma, ha visto le proprie attività e proposte rovesciate dalla dirigenza dell’azienda.

Un altra questione centrale ai Facebook Files è il fatto che, benché Facebook concentri la schiacciante maggioranza dei propri sforzi sugli Stati Uniti, molte delle persone la cui sofferenza è stata esacerbata da Facebook o Instagram vivono in Paesi completamente fuori dai radar della compagnia. Per dirla con Ellen Cushing di The Atlantic, “questi documenti mostrano che Facebook che abbiamo negli Stati Uniti è in realtà la piattaforma migliore. È la versione fatta da persone che parlano la nostra lingua e capiscono i nostri costumi, che prendono sul serio i nostri problemi civici perché quei problemi sono anche i loro. È la versione che esiste su un Internet gratuito, sotto un governo relativamente stabile, in una ricca democrazia. È anche la versione a cui Facebook dedica più risorse di moderazione. Altrove, mostrano i documenti, le cose sono diverse. Nelle parti più vulnerabili del mondo, luoghi con accesso a Internet limitato, dove un numero di utenti inferiore significa che i cattivi attori hanno un’influenza indebita, i compromessi e gli errori che Facebook commette possono avere conseguenze mortali”.

Due anni fa, ad esempio, Apple ha minacciato di rimuovere Facebook e Instagram dall’app store perché preoccupata del fatto che in Medio Oriente le piattaforme fossero usate per la compravendita di domestiche filippine, poi ridotte praticamente in schiavitù in contesti in cui i diritti dei lavoratori stranieri sono inestistenti. A questo si aggiunge il fatto che la piattaforma ha permesso la proliferazione costante di odio verso le donne e la comunità LGBTQ+ in lingua araba, cancellando però tantissimi contenuti innocui per “terrorismo”.

Verrebbe da dire che è una regola non scritta, ma in alcuni frangenti è una vera e propria policy dell’azienda. Secondo un report del 2020, l’84% degli sforzi contro la disinformazione è stato dedicato agli Stati Uniti. Un anno prima, una riorganizzazione delle risorse ha visto Facebook dividere i vari Paesi in livelli, in base alle priorità dell’azienda. Al livello zero, con massima priorità, solo Brasile, India e Stati Uniti: per loro sono state create delle “war room” adibite a controllare costantemente le attività sulla rete e una linea diretta per avvisare i funzionari locali di eventuali problemi in vista delle elezioni. Al livello 1 troviamo l’Italia, ma anche Germania, Indonesia, Iran e Israele, che hanno ricevuto risorse simili – con traduzioni degli standard delle comunità nella lingua ufficiale del Paese assicurate, intelligenze artificiali capaci di individuare l’hate speech e la disinformazione in quelle lingue e un teama dedicato ad analizzare i contenuti virali. Al secondo livello altri 22 Paesi, senza “war room” ma con dei “centri operativi avanzati”. Per tutto il resto del mondo, Facebook ha deciso di intervenire solo nel caso in cui i moderatori di contenuti avessero trovato qualcosa di sospetto relativo alle elezioni.

Peccato che, anche così, nel dicembre 2020 la compagnia sapeva che gli sforzi per avere abbastanza esperti che parlassero la lingua dei vari Paesi erano falliti in quattro dei dieci Paesi nel livello uno, e in tutti i Paesi del livello due e tre. In Myanmar (che ha attraversato quest’anno un colpo di stato) e Etiopia (nel bel mezzo di un sanguinoso conflitto civile) Facebook non aveva messo a disposizione mezzi che individuassero disinformazione e incitamento all’odio sulle loro piattaforme. Secondo i documenti, dopo che un Paese è stato designato come prioritario, in genere ci vuole almeno un anno per creare classificatori per l’hate speech.

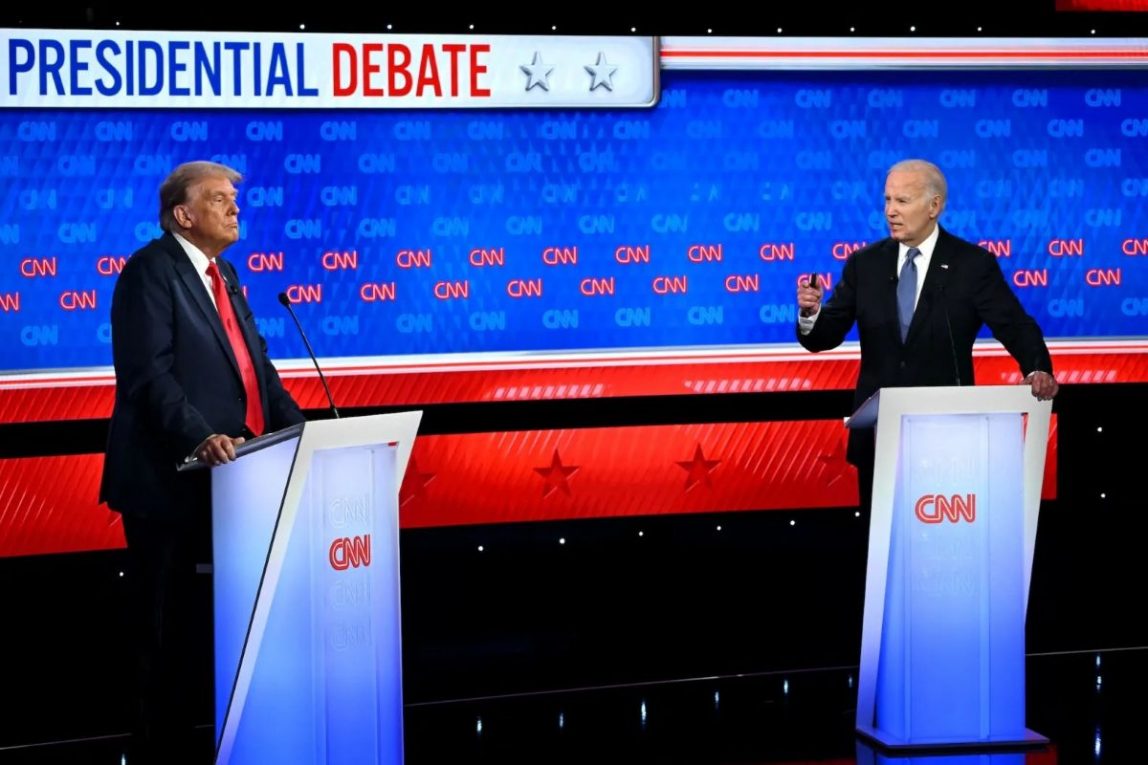

Neanche negli USA, che ottengono comunque più attenzione e risorse degli altri posti, è andato tutto bene. Secondo documenti interni, dopo le elezioni del 6 novembre 2020 Facebook ha annullato gran parte delle misure che aveva messo in piedi per salvaguardare gli utenti americani – lasciando via libera per le campagne coordinate di disinformazione secondo cui Joe Biden non era il presidente legittimo del Paese. Il tutto è culminato nell’attacco al Campidoglio del 6 gennaio, organizzato anche su diversi gruppi Facebook. “La storia non ci guarderà di buon occhio”, scriveva in quelle ore un dipendente dell’azienda nella chat pubblica. La compagnia è stata anche a guardare mentre gli utenti si radicalizzavano dietro a teorie del complotto come QAnon o diventavano antivaccinisti.

E questa è solo la prima settimana di leak seri. Tutto questo scrutinio potrebbe portare a una resa dei conti sul ruolo monopolistico di Facebook e sulla sua stazza fuori controllo. O il quantitativo immenso di notizie che stanno uscendo potrebbe avere l’effetto di sommergere il pubblico con talmente tante informazioni da non sapere che farsene.