Bob Dylan ha cantato Baby One More Time di Britney Spears. Non oggi, nel 1963. È il cortocircuito temporale causato da una traccia audio pubblicata su YouTube dall’account Vocal Synthesis. La linea melodica è a dir poco approssimativa, ma il risultato è tutto sommato credibile, a tratti impressionante. La voce che interpreta il testo dell’hit di Britney Spears non è quella di un imitatore, sembra davvero quella di Dylan ai tempi di Blowin’ in the Wind e It Ain’t Me Babe. E in un certo senso lo è: è stata ricreata da un’intelligenza artificiale in base allo studio del modo in cui il folksinger cantava e pronunciava le parole.

Si chiamano deepfake, sono audio e video generati tramite software al fine di ricreare movenze e voci di persone esistenti. La versione video è stata sperimentata nel porno, per la gioia di chi desidera vedere la sua attrice preferita alle prese con performance che sul grande schermo non arriveranno mai. Vengono usati nell’industria dell’intrattenimento, possono diventare armi di disinformazione politica. Il grande pubblico italiano ne ha avuto un assaggio l’anno scorso, quando Striscia la Notizia ha mostrato un finto fuorionda di Matteo Renzi che parlava della «faccia da pretino» di Giuseppe Conte. In quell’occasione prevedevamo che sarebbe arrivato il momento in cui questa tecnologia sarebbe stata applicata anche alla parola cantata e sul mercato sarebbero arrivati finti inediti di Amy Winehouse o Lucio Battisti prodotti da un’intelligenza artificiale.

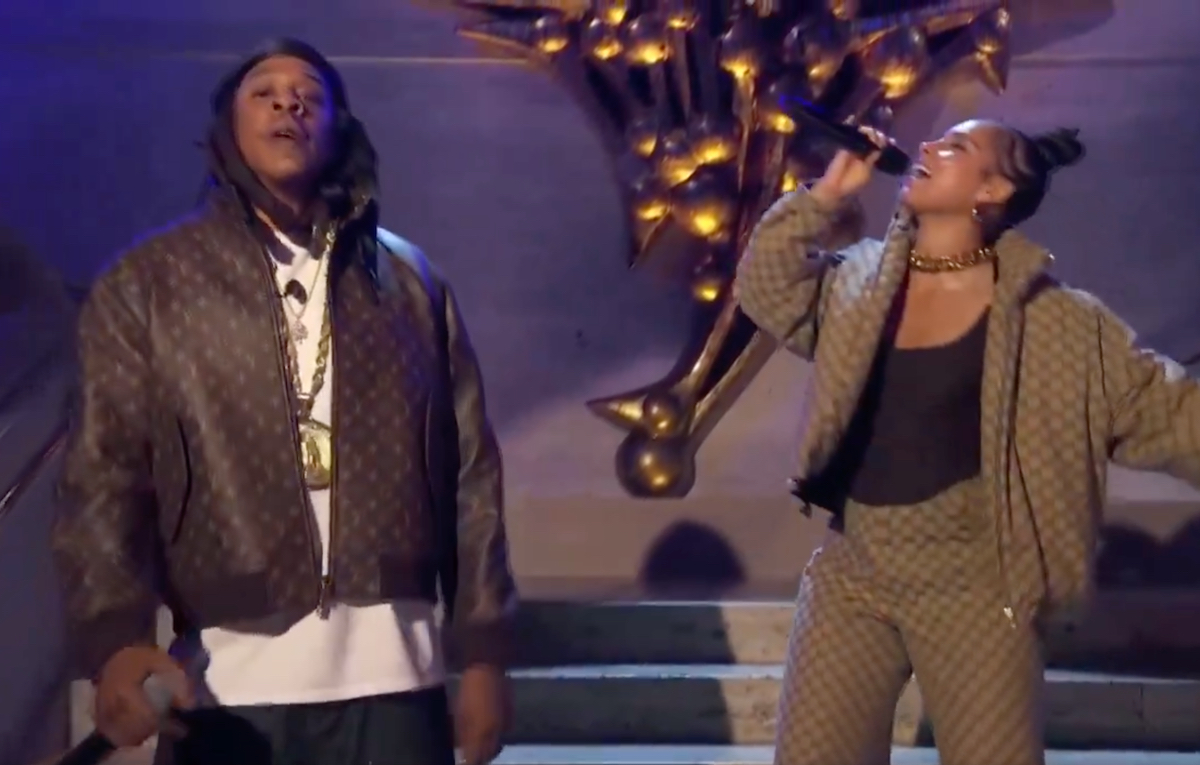

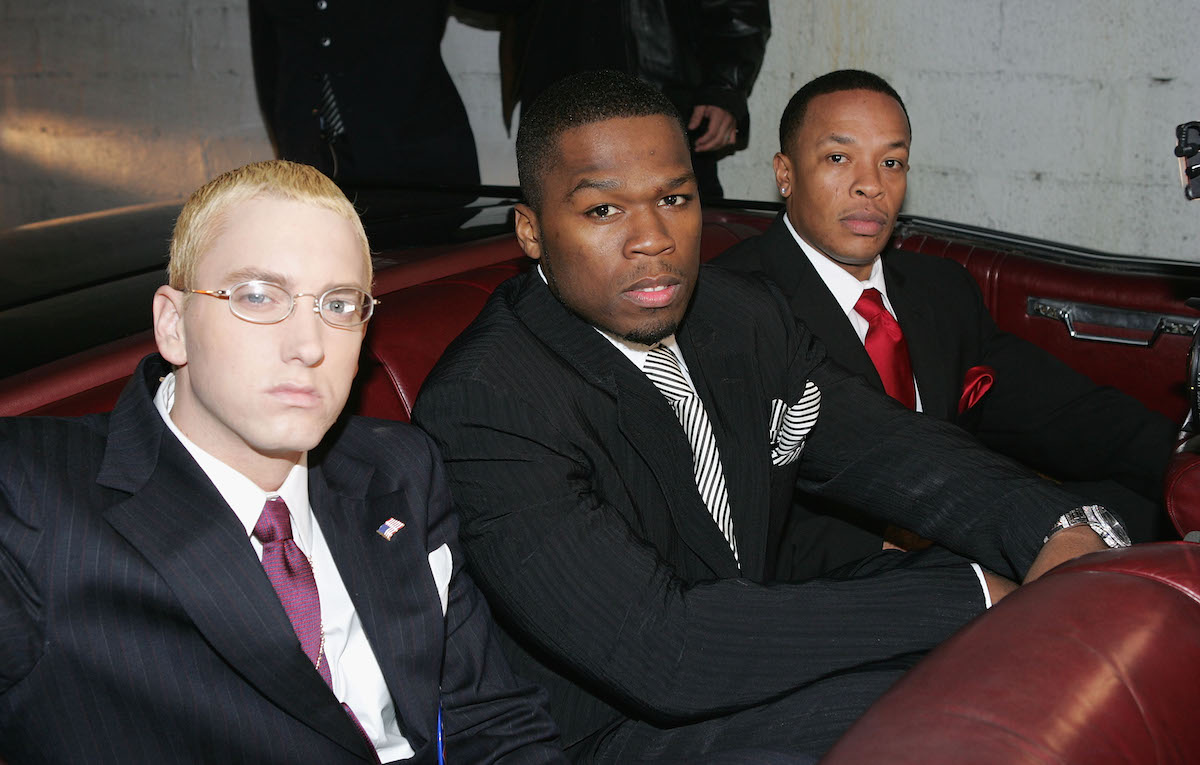

Quel momento non è ancora arrivato, ma è sempre più vicino. Nell’ultimo mese, Vocal Synthesis ha pubblicato una serie di audio deepfake particolarmente credibili. Solo alcuni hanno a che fare con la musica. C’è ad esempio l’ex presidente George W. Bush che recita In Da Club di 50 Cent con la sua tipica cadenza e il suo timbro caratteristico. Fa una certa impressione anche John F. Kennedy che legge il discorso inaugurale di Donald Trump o il copypasta “They targeted gamers” (commento: «God bless John Fortnite Kennedy»). Ci sono anche audio come quello citato di Dylan, uno di Frank Sinatra che canta (male) Dancing Queen degli ABBA e uno particolarmente controverso di Jay-Z che recita il testo di We Didn’t Start the Fire di Billy Joel.

Sono audio imperfetti. I testi delle canzoni sono recitati e non intonati, certe parole non sono scandite perfettamente, ci sono sbalzi di volume, a volte la voce assume un timbro fastidiosamente metallico, ma nei passaggi migliori suonano verosimili. Ed è solo l’inizio. È facilmente immaginabile che presto le voci prodotte dell’intelligenza artificiale potranno cantare a ritmo e all’altezza desiderata, e somiglieranno sempre più agli originali. Col risultato che non sarà facile distinguere una performance vera da una ricreata al computer.

I video di Vocal Synthesis non sono pubblicati con intento mistificatorio, e del resto Dylan sarà pure considerato un profeta, ma è difficile credere che da giovane cantasse una canzone del 1998. È chiaro, insomma, che si tratta di deepfake, tanto più che sono accompagnati da un link alla tecnologia usata. Si chiama Tacotron 2 e a partire da campionamenti audio della voce del cantante genera parti parlate in modo naturale che tengono conto della pronuncia, del volume del parlante, della velocità con la quale si esprime solitamente, dell’intonazione e di altre sfumature.

Pur essendo deepfake pubblicati a scopo dimostrativo, gli audio di Vocal Synthesis suscitano qualche domanda. Una delle più importanti è: a chi appartiene la voce di un artista generata da un’intelligenza artificiale? Prendiamo in considerazione il caso futuribile di una canzone originale, scritta ad hoc da autori in carne ed ossa o anch’essa prodotta da un’intelligenza artificiale, che viene interpretata dalla voce di Madonna. Non quella vera, ma prodotta da un’IA. Questa voce non viene generata dal nulla, ma è il risultato di un’analisi condotta da un software su esempi del canto di Madonna. Trattandosi di un pezzo inedito si potrebbe pensare ragionevolmente che appartenga a chi l’ha scritto e prodotto. Oppure, in un mondo che tutela l’originalità delle creazioni e l’identità degli artisti anche in caso di assonanze, come ha dimostrato la guerra del copyright, l’artista potrebbe chiedere il ritiro dal mercato e un risarcimento economico. E questo beninteso anche se non vi è alcun dubbio sul fatto che quello non è un singolo di Madonna.

È la direzione in cui si è mosso Jay-Z in relazione ai deepfake di Vocal Synthesis che lo vedono protagonista. Stando a un articolo pubblicato da Pitchfork, i video relativi al rapper sono stati cancellati a causa di problemi di copyright sollevati da Roc Nation e poi rimessi online nel giro di due giorni. L’agenzia fondata da Jay-Z afferma che il contenuto utilizzava illecitamente un’intelligenza artificiale per impersonare la voce del rapper. C’è invece chi sostiene che non sia possibile tutelare uno stile vocale come si fa con la linea melodica di una canzone. I creatori di Vocal Synthesis hanno commentato la controversia con Jay-Z in un video. O meglio, l’hanno fatta commentare alle voci di Barack Obama e Donald Trump, uniti per spiegare che lo scopo del canale è intrattenere con video divertenti. «È stata una delusione per me e Donald» dice l’ex presidente «scoprire che Jay-Z e Roc Nation hanno deciso di prendere di mira un piccolo YouTuber».

Chi ha ragione? E che cosa accadrà quando la tecnologia ci darà modo di far cantare qualunque canzone a Beyoncé, Lady Gaga, Bono o Bruce Springsteen? Se spiego che non si tratta dell’originale, posso liberamente usare la voce di un artista per fargli dire o interpretare qualunque cosa? Chi difende questa posizione tende a equiparare la performance dell’intelligenza artificiale a quella di un imitatore come, per fare un paio di esempi italiani risalenti agli anni ’90, gli Audio 2 che cantavano nello stile di Battisti o Anonimo Italiano in quello di Baglioni. Ma questa cosa che sta nascendo non è un’imitazione e non è nemmeno un campionamento della voce originale inserita in un nuovo contesto, come si usa fare da sempre nell’hip hop. È qualcosa di nuovo e potenzialmente esplosivo a cui i legislatori dovranno dare un nome e una funzione.