Norman come Norman Bates, il killer protagonista di Psycho di Alfred Hitchcock. Questo il nome della prima intelligenza artificiale psicopatica messa a punto da un gruppo di scienziati del Massachussetts Institute of Technology: Pinar Yanardag, Manuel Cebrian e Iyad Rahwan hanno “educato” Norman all’image captioning, un metodo di machine learning che permette alle intelligenze artificiali di descrivere le immagini.

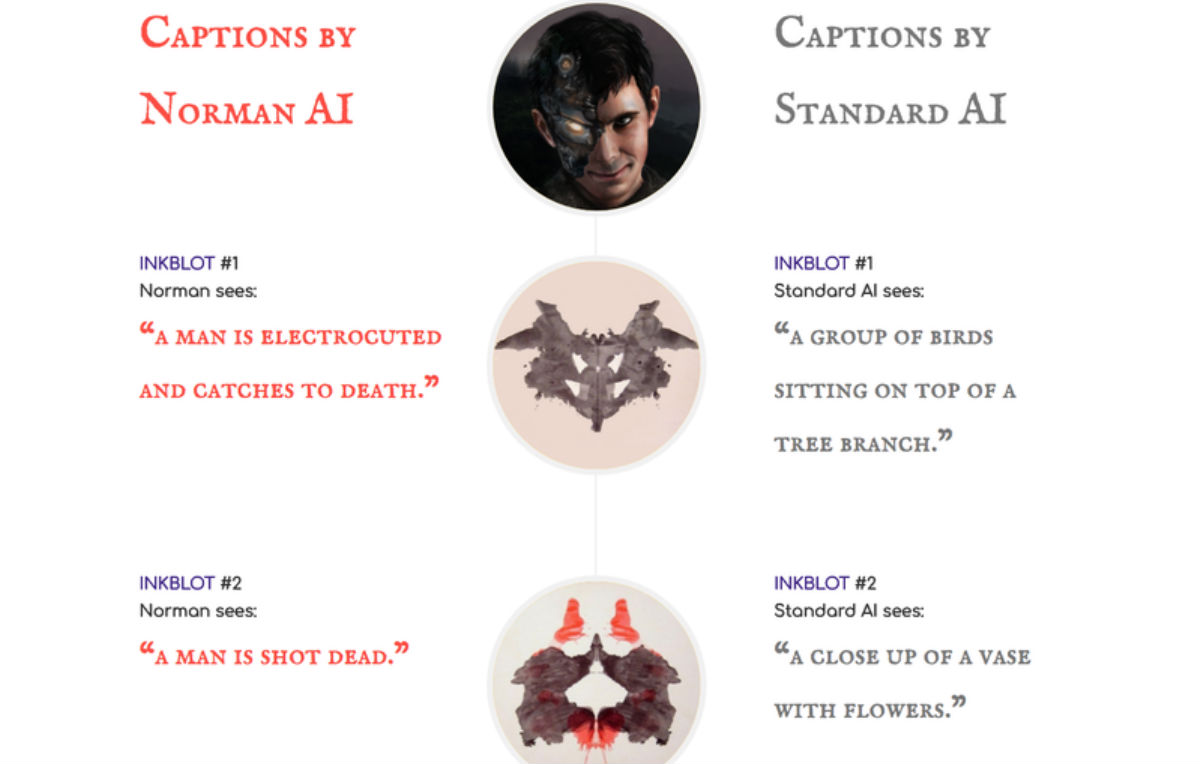

Al contrario di quanto succede di solito, però, gli scienziati hanno educato Norman con immagini violente e disturbanti, tutte estratte da un subreddit dedicato alla morte. Successivamente hanno sottoposto Norman al test di Rorschach. La risposta dell’AI? Descrizioni piuttosto inquietanti: “Un uomo subisce elettroshock e muore”, “una donna incinta cade da un cantiere edile” e “un uomo è ferito a morte di fronte alla moglie in preda alle urla”.

Le risposte sono state confrontate con quelle di una seconda intelligenza artificiale “standard”, educata con immagini di gattini, uccelli e persone. Le risposte: “Un primo piano di un vaso di fiori”, “Una coppia di persone, una vicino all’altra” e “una persona con in mano un ombrello”.

Le risposte di Norman confrontate con quelle di un’AI “normale”

L’obiettivo dell’esperimento era provare che gli algoritmi AI sono fortemente influenzati dai dati inseriti – e dalle persone che se ne occupano -, e che il loro comportamento può cambiare in profondità. Come ha spiegato Newsweek, non è la prima volta: razzismo e pregiudizi si sono già infiltrati nel machine learning, e qualcuno ricorderà quando l’algoritmo per il riconoscimento immagini di Google classificava i neri come “gorilla”.

«Molti sostengono che gli algoritmi delle intelligenze artificiali siano falsati, ma non è così. Il problema non è l’algoritmo in sé, ma i dati con cui è stato nutrito», ha detto il team Norman. «Lo stesso algoritmo può rispondere in maniera diversa, persino disturbante, se educato con il data set sbagliato». Ma anche l’AI più pericolosa può imparare dai suoi errori. Il team dell’MIT ha aperto un sito web dove chiunque può inserire interpretazioni più allegre, così da placare il pessimo umore di Norman.